Deepfake in AI goljufije pri avtomobilskih zavarovanjih in Airbnbu

Prevare

• INFORMACIJSKA VARNOST • KIBERNETSKA VARNOST • PREVARA • DEEPFAKE • GOLJUFIJA • INSURANCE SCAM •

V zadnjih letih so umetna inteligenca in generativna orodja za slike postala nova orožja v svetu prevar. Kar se je začelo kot fascinantna tehnologija, se hitro spreminja v nevarno sredstvo za goljufe, ki iščejo hitre dobičke pri avtomobilskih zavarovanjih in najemih preko platform, kot je Airbnb.

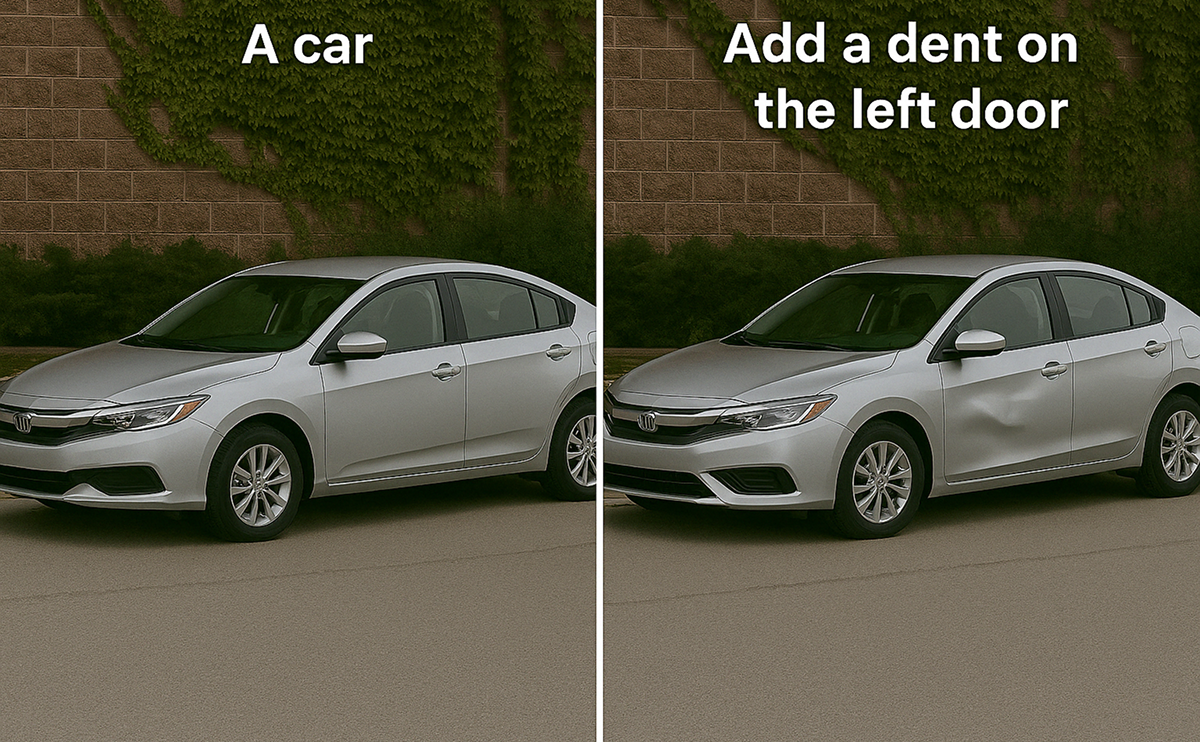

Lažne poškodbe avtomobila z enim klikom

Ena od pogostih prevar pri zavarovanju avtomobilov je povezana s fotografijami vozil. Nekdo lahko na primer uporabi umetno inteligenco, da ustvari sliko avtomobila brez poškodb, medtem ko je v resnici poškodovan, in nato odda zavarovalno polico. Po nekaj mesecih vloži zahtevo za odškodnino za škodo, ki naj bi bila resnična. Druga možnost je obrnjena: goljuf pretvarja, da je do poškodbe prišlo pri vozilu, ki je v resnici v odličnem stanju, da bi prejel odškodnino.

Prejšnji mesec je Instagram račun »Evolving AI« objavil sliko, ki je prikazovala, kako enostavno je s pomočjo AI umetno ustvariti poškodbe na resnični fotografiji avtomobila. To naj bi opozorilo na hitro naraščajočo uporabo umetne inteligence v zavarovalniških prevarah. Za zavarovalne strokovnjake v Veliki Britaniji to ni novost. Po podatkih Sprout.AI se je od leta 2021, ko je bila predstavljena prva različica OpenAI-jevega modela DALL-E, povečalo število sumljivih zavarovalnih zahtevkov – 65 odstotkov britanskih zavarovalnih agentov je opazilo porast lažnih zahtevkov.

Podjetja, kot je Allianz, so med letoma 2021 in 2023 zabeležila 300-odstotno povečanje primerov uporabe aplikacij za manipulacijo slik, videov in dokumentov. Goljufi, ki upajo, da bodo s pomočjo novih tehnologij ušli kazni, pa se motijo. Lažne zahteve so kaznivo dejanje, za katerega lahko po britanskem Zakonu o prevarah iz leta 2006 zagrozijo globe do 5.000 funtov ali celo do deset let zapora, če gre za hujše ali ponavljajoče se kršitve. Poleg tega lahko registracija kot zavarovalniški prevarant močno oteži prihodnje sklepanja zavarovanj.

Airbnb: ko gostitelj “poškoduje” stanovanje kar sam

A nevarnost ni omejena le na avtomobilsko industrijo. Tudi platforme za kratkoročni najem, kot je Airbnb, so postale tarča AI prevar. Ena izmed nedavnih zgodb prihaja iz Londona: študentka je najela stanovanje v Manhattnu, a se je odločila predčasno odjaviti, ker se ni počutila varno. Po njenem odhodu je gostitelj trdil, da je povzročila za več kot 16.000 ameriških dolarjev škode, in poslal fotografije poškodovanega pohištva – vključno s popraskano mizo, umazano posteljo in poškodovanim robotom za sesanje.

Študentka je po natančnem pregledu ugotovila, da so slike umetno ustvarjene z AI, saj so bile majhne vizualne razlike med fotografijami istega predmeta nezdružljive z realnostjo. Airbnb je po pregledu primer ocenil na okoli 7.000 dolarjev škode, študentka pa je vztrajala in dokazala, da so bili dokazi ponarejeni. Na koncu je Airbnb povrnil celoten znesek in odstranil negativno oceno gostiteljice.

Primeri, kot sta ta, kažejo, kako enostavno je z AI ustvariti lažne dokaze in kako lahko tehnologija spremeni dinamiko goljufij. Pri avtomobilskih zavarovanjih goljufi lahko z lažnimi fotografijami zahtevajo odškodnino, pri Airbnbu pa bodisi gostitelji bodisi najemniki lahko uporabljajo AI za izmišljanje škode in prejem denarja ali povračil.

Za zavarovalce in platforme pomeni to nov izziv. Pri avtomobilskih zahtevkih preverjajo vse dokaze, od pisnih izjav in fotografij do video posnetkov z dash cam in podatkov črnih skrinjic. Vsaka nepravilnost ali neskladnost lahko sproži dodatno preiskavo. Za uporabnike pa je opozorilo jasno: nikoli ne spreminjajte fotografij, vedno dokumentirajte realno stanje in bodite pozorni na sumljive zahteve drugih.

Prevar z AI ne smemo jemati kot “brez žrtev”. Takšne taktike lahko pripeljejo do izgube denarja, težav z zavarovanji in kazenskih posledic. Primeri lažnih avtomobilskih zahtevkov ali Airbnb škod dokazujejo, da je hitra digitalna manipulacija nova realnost.

Nasvet za posameznike

Z vidika kibernetske varnosti in forenzike je val visokokakovostnih deepfake slik za zavarovalnice resen operativni problem. Današnji modeli (2025) dosegajo tako visoko stopnjo fotorealizma, da klasični detektorji (npr. na osnovi CLAHE, noise analysis ali Microsoft Video Authenticator) zanesljivo zaznajo le še okrog 60–70 % primerov. Zavarovalnice se zato vse bolj zanašajo na profiliranje strank in socialno mrežno analizo namesto na samo analizo slik.

- Pregled vseh javnih profilov (Instagram, Facebook, TikTok, X) – ali se poškodbe na avtu pojavijo že pred “nesrečo”?

- Preverjanje povezav med vpletenimi – avto je bil pred kratkim prodan “naključnemu” kupcu, a sta oba obiskovala isto srednjo šolo ali imata skupne prijatelje? – je rdeča zastavica za organizirano goljufijo.

Za zavarovalnice val deepfake slik predstavlja pravo grožnjo, saj je kakovost generiranih posnetkov izjemno visoka. Zato vse pogosteje uporabljajo prav AI-profiliranje in preverjanje socialnih omrežij strank, iščejo povezave (npr. avto prodan osebi, ki je hodila v isto šolo pred leti) in neskladja v časovnici dogodkov – takšni vzorci so pogosto edini zanesljivi pokazatelj organizirane prevare.

Vedno fotografirajte/videoposnemajte realno stanje (z vidnim datumom in lokacijo v EXIF), nikoli ne urejajte ali “popravljajte” fotografij za zavarovalnico ali Airbnb, in takoj prijavite sumljive zahtevke. V letu 2025 lažni dokazi niso več samo “slaba Photoshop montaža” – so kaznivo dejanje z resnimi posledicami.

clanek035